DeepSeek本地部署保姆级教程分享

- 作者:佚名

- 来源:188dm下载

- 时间:2025-09-20

DeepSeek是深度求索推出的一款功能强大的AI大模型,于25年1月11日上线,DeepSeek-R1 性能对标 OpenAI o1 正式版,其手机版应用一度登顶过美区App Store单日下载量榜首,对ChatGPT的统治性地位乃至世界AI格局产生了不小的冲击,让DeepSeek的身影出现在了更多大众的视野中。

但由于DeepSeek频繁遭受网络攻击与访问量过大的缘故,用户在与DeepSeek对话时,总会出现“服务器繁忙,请稍后再试。”,这可让不少小伙伴感到头疼,那么有什么好的方法能够解决这一情况?

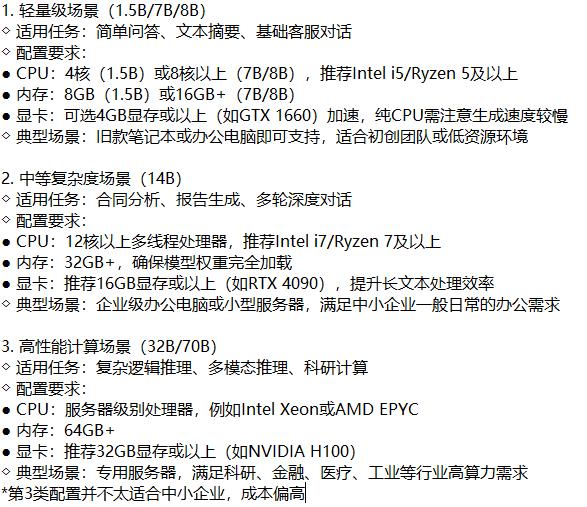

答案是有的,那就是通过用户本地部署DeepSeek大模型,但此方法较为吃电脑配置,普通用户最多本地部署个“残血版”DeepSeek模型,使用体验并没有官网“满血版”那么好,不过你的使用要求、对信息的时效性没有那么高也是能够勉强使用的,接下来就进入正题,为大家分享DeepSeek本地部署保姆级教程。

通过Ollama实现本地部署DeepSeek-R1大模型详细步骤(多数大模型部署通用)

①本地安装Ollama

这里给大家解释一下,Ollama是一个开源框架,有了它,你就可以在本地跑大模型,至于其它的就别管了,知道这一点就够了。

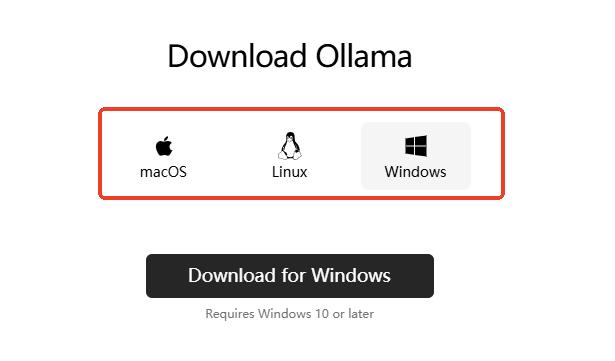

进入Ollama官网,选择合适的版本下载即可。

官网:

根据你的系统选择您需要下载的Ollama版本。

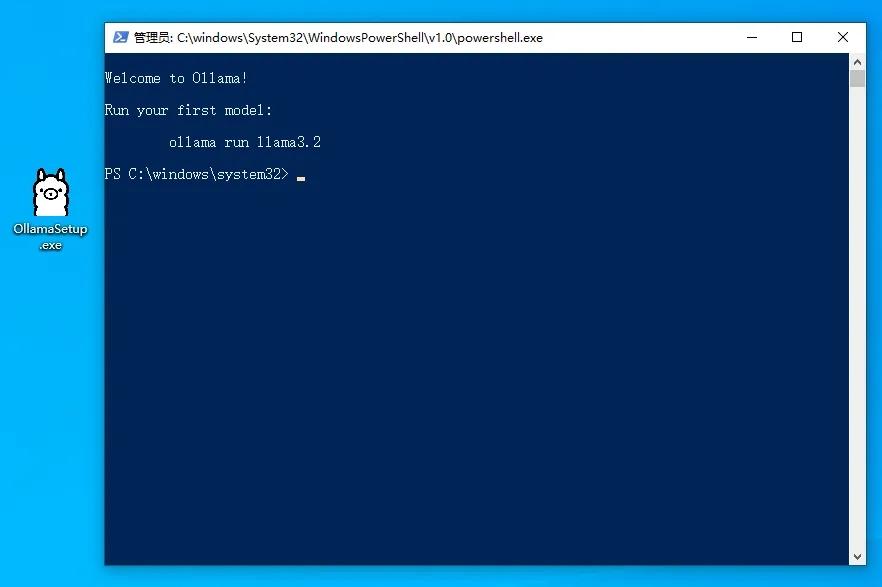

下完点击安装,安装成功会弹出一个命令行界面,Ollama本身是没有可视化界面的,但并不影响后续使用,毕竟它只是一个框架。

完成上述步骤后,基础就打好了。

②下载DeepSeek-R1模型

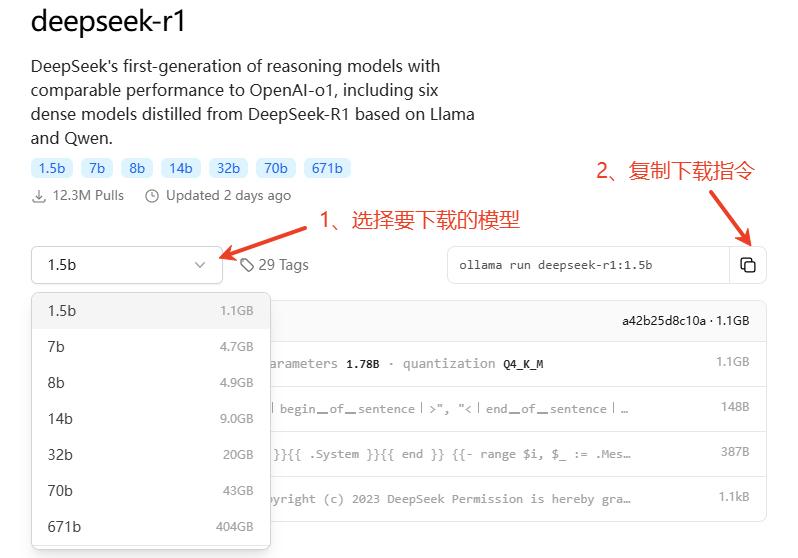

访问下方链接,选择要下载的模型,并在右侧复制对应的命令,这里以最小的1.5b版本作为演示。

选择好您要下载的模型,并复制下载的指令。

DeepSeek-R1模型相关参考标准如下:

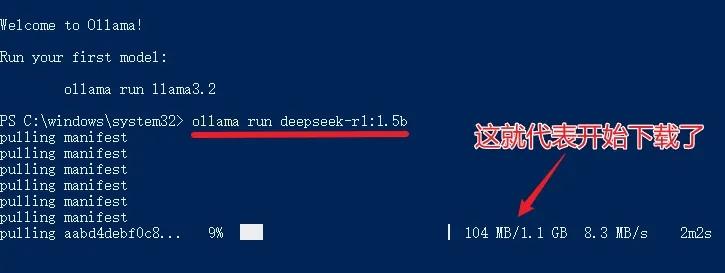

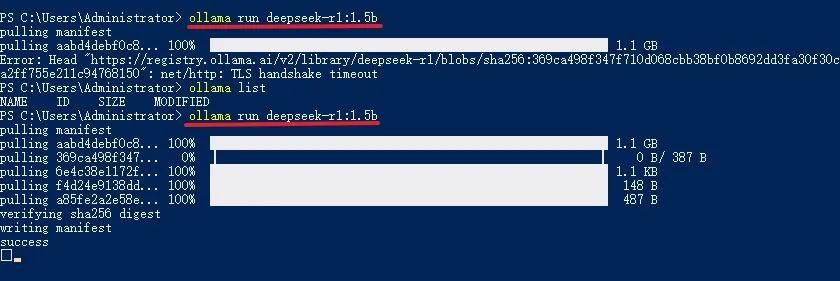

以1.5b版本为例,复制命令后粘贴到命令行中运行即可下载,速度取决于你的网速。

如果下载完成后报错,就再运行一遍下载命令,提示“success”就代表下载完成了。

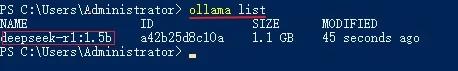

然后在命令行里输入“ollama list”来查看下载成功的模型,下图这种情况就代表一切准备就绪了。

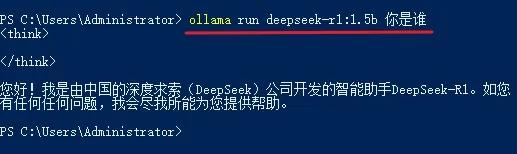

接着在命令行里输入「ollama run deepseek-r1:1.5b+问题」即可进行AI对话,如果你下的是7b模型,那么就是输入「ollama run deepseek-r1:7b+问题」,以此类推。

显然,通过命令行对话有点太Low了,所以咱们还得借助一个第三方AI客户端来调用本地模型,让体验更上一层楼。

③通过Cherry Studio调用模型

官网(Win+Mac+Linux):

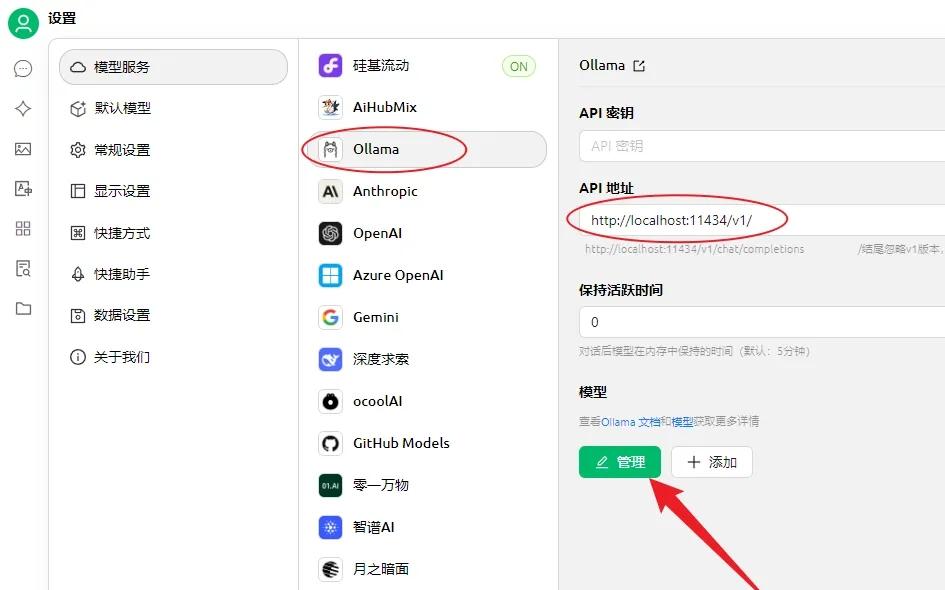

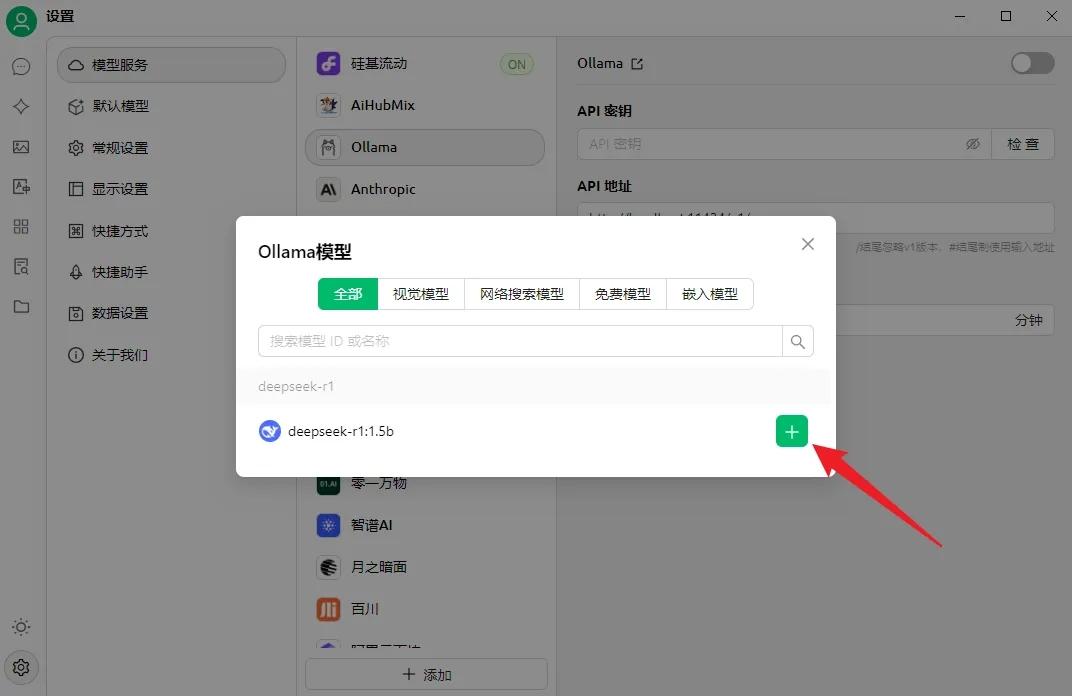

下载后打开客户端,进入设置,选择「Ollama」,API地址会自动填写,需要与下图中的地址保持一致,然后点击“管理”。

在弹出的窗口中可以看到自己本地的模型,点击右侧的按钮添加模型即可。

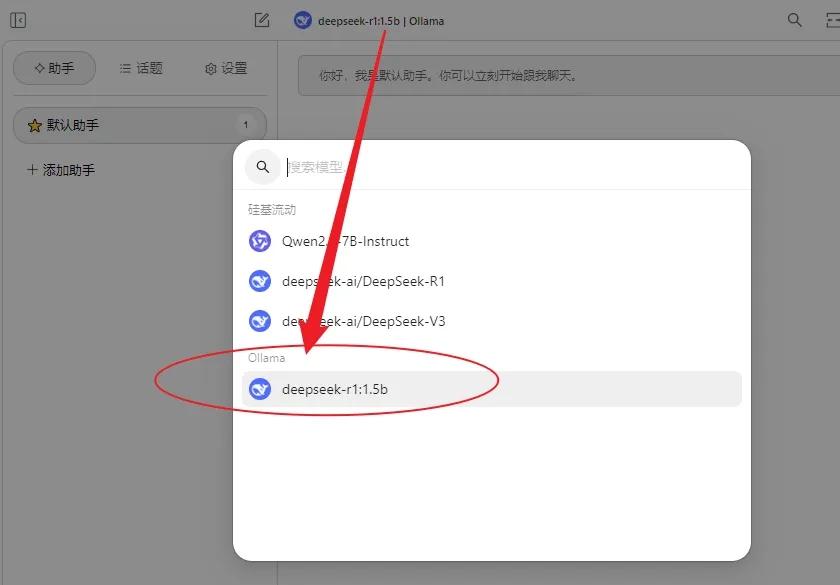

最后进入对话页面,点击顶部模型名称切换成本地部署的模型,至此大功告成。

下一篇:steam怎么查看历史登录ip